Wer seine Website nicht regelmäßig pflegt, verliert auf lange Sicht hin Kunden und Nutzer. Nach Einschätzung des Controlling- und Targeting-Anbieter etracker sollten Optimierungsmaßnahmen jedoch nie ohne vorheriges A/B-Testing durchgeführt werden. Trotz der simplen Idee, die Besucher mit verschiedenen Online-Präsenzen als Testkaninchen einzusetzen, können einige Fallstricke das Vorhaben schnell zum Scheitern verurteilen.

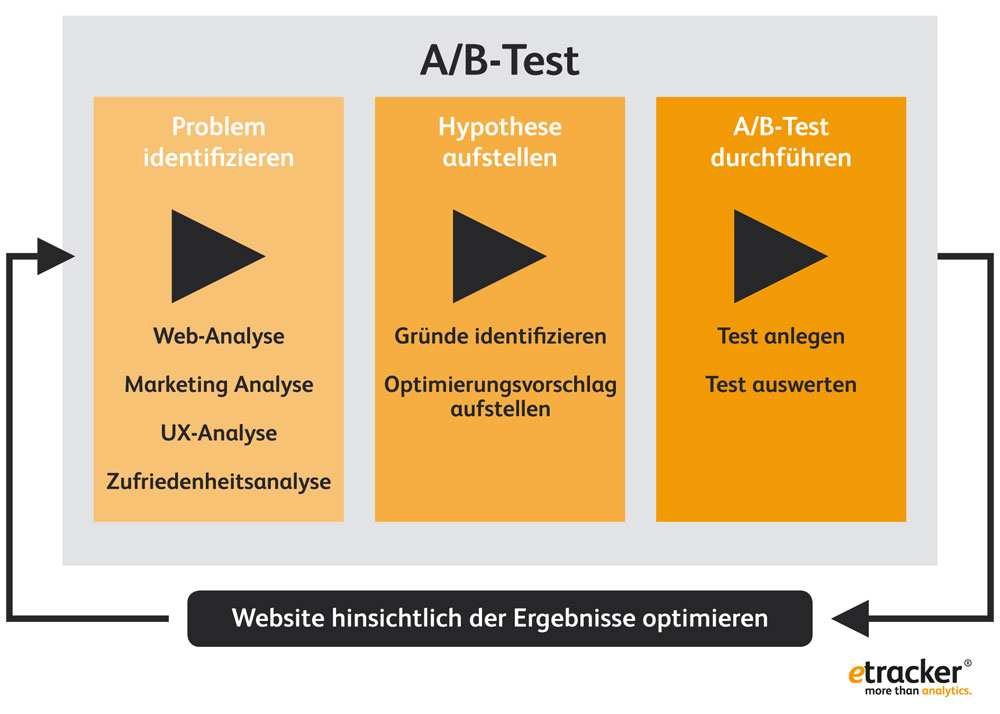

Nicht wild drauf los testen. Beim A/B-Testing gilt immer die Reihenfolge „Problem, Hypothese, Testing“. Quelle: etracker.

- Wildes Testen ohne Strategie: Grundsätzlich sollten Marketingverantwortliche nicht ohne die richtige Strategie handeln. Nach der Identifizierung des Problems sollte besser eine Hypothese formuliert werden: „Wenn ein Problem durch Optimierungsvorschlag verändert wird, erreichen wir eine Verbesserung von erwartetes Ergebnis.“

- Achtung Fehlerteufel: Beim Start des A/B-Testings müssen Marketingverantwortliche explizit die Funktionalität sowie die Anzeige der Varianten in unterschiedlichen Browsern und auf diversen Endgeräten prüfen. Fehler an dieser stelle sind unverzeihlich, weil das Ergebnis durch eine fehlerhafte Testumgebung schnell verfälscht werden kann.

- Zu hohe Ziele: Sobald zu viele Faktoren wie „mehr Bestellungen“ oder „mehr Umsatz“ als Ziel eines A/B-Tests definiert werden, kann das Testergebnis verfälscht werden. Daher eignen sich Low-hanging-fruits, also kleinere Conversion-Ziele bzw. Mikro-Conversions. Der Klick auf einen neuen Call-to-Action-Button kann das effizientere Ziel sein, als direkt den Abverkauf aller Produkte anzukurbeln.

- Duplicate Content würgt SEO-Ranking: Vorsicht ist beim Suchmaschinenranking geboten, denn dieses kann durch A/B-Tests schnell verschlechtert werden. Der Seiteninhalt sollte sich dynamisch ändern, damit der Google-Crawler immer nur die Originalseite und nicht die zusätzlichen Testszenarien durchsucht.

- Zu schnell Ende im Gelände: Die Datenmenge muss groß genug sein, um die erfolgreiche Variante mit statistischer Signifikanz zu bestimmen. Bis zu 1000 Besucher pro Test sind empfehlenswert – je nachdem, wie stark sich die Conversion-Rate der Testversion vom Original unterscheidet.

- Aus den Augen aus dem Sinn: Je länger ein A/B-Test läuft, desto höher steigt die Wahrscheinlichkeit auf Umsatzeinbußen – besonders dann, wenn die neue Alternative nicht die definierten Conversion-Ziele erreicht. Hier steuern Automatismen dagegen, die eine eindeutige Gewinnervariante schneller erkennen und diese mehrheitlich den Nutzern ausspielen.

- Testing ohne Segmentierung: Zwar werden A/B-Tests über alle Kundengruppen durchgeführt, jedoch sollten Marketingverantwortliche die Ergebnisse immer nach Wiederkehrern oder Stammkunden segmentieren. Je nach Besuchergruppe und Verhalten können dann personalisierte Websiteinhalte automatisch ausgespielt werden.

Fakt ist, dass Optimierungen an Website oder Onlnie-Shop nicht als eine einmalige Nummer, sondern als eine kontinuierliche Aufgabe verstanden werden darf. Die richtigen Analysen respektive das entsprechende A/B-Testing helfen dabei, sich nur für die erfolgversprechenden Maßnahmen zu entscheiden.